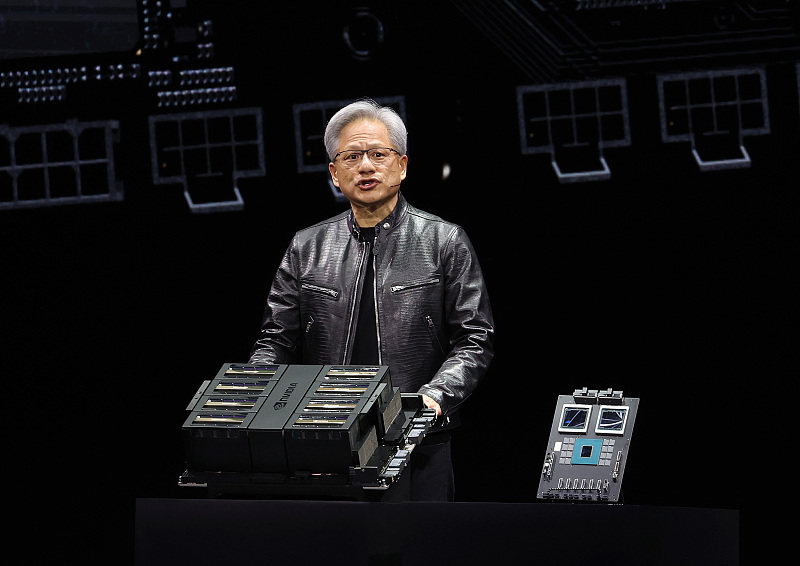

图片来源:视觉中国

北京时间3月19日凌晨,英伟达GTC(GPU 技术大会)上,英伟达首席执行官黄仁勋公布了 Hopper架构芯片的继任者——Blackwell架构的B200芯片。目前英伟达Hopper架构的芯片H100 和 GH200 Grace Hopper 超级芯片需求量很大,为世界上许多最强大的超级计算中心提供算力,而B200将提供算力的进一步代际飞跃。

Blackwell架构的B200芯片并不是传统意义上的单一GPU。相反,它由两个紧密耦合的芯片组成,尽管根据 Nvidia 的说法,它们确实充当一个统一的 CUDA GPU。这两个芯片通过 10 TB/s NV-HBI(Nvidia 高带宽接口)连接进行连接,以确保它们能够作为单个完全一致的芯片正常运行。

多卡互联是B200算力提升的关键。将两个 GPU 与单个 Grace CPU 结合在一起的 GB200 可以为大语言模型的推理工作提供 30 倍的性能,同时还可能大幅提高效率。英伟达称,与 H100 相比,B200可将生成式AI的算力成本和能耗降低多达 25 倍。

英伟达AI芯片性能本身在算力上的提升主要靠数据精度,从FP64、FP32、FP16、FP8到如今B200芯片的FP4,FP4最大理论计算量为 20 petaflops(数据精度单位)。FP4是 FP8性能的两倍,FP4的好处是提升了带宽,通过为每个神经元使用 4 位而不是 8 位,使计算、带宽和模型大小加倍。如果将B200换算成FP8与H100进行同类比较,那么 B200理论上仅比 H100提供多 2.5 倍的计算量,B200的算力提升很大一部分来自于两个芯片互联。

CPU通用处理器时代的摩尔定律(集成电路上可容纳的晶体管数目,约每隔18个月便会增加一倍)已经进入暮年。台积电在3nm制程上的突破,并未给芯片性能带来突破代际的提升。2023年9月,苹果A17 Pro问世,使用了台积电生产的首个3nm制程芯片,但CPU性能只有10%的提升。且先进制程芯片研发耗资巨大,据远川研究所报道,2023年台积电的晶圆代工价格与两年前相比大约上涨了16%(先进制程)到34%(成熟制程)。

除了苹果之外,台积电的另一大芯片客户便是英伟达——英伟达的硬通货AI芯片H100就采用了台积电N4(5nm)工艺,使用了台积电的CoWoS先进封装产能。

摩尔定律失效,黄仁勋的黄氏定律指出,GPU的效能每两年将增加一倍以上,“创新不仅仅是芯片,而是整个堆叠”。

英伟达继续朝着多卡互联进发。既然3nm芯片提升有限,英伟达的B200选择把2片4nm芯片并排摆放,通过超高速片上互联,组成一个2000多亿晶体管的超大芯片。在英伟达GTC上,黄仁勋对于芯片本身性能一笔带过,重点都在DGX系统上。

在多卡互联方面,英伟达的NVLink和NVSwitch技术是其护城河。NVLINK 是一种点对点的高速互连技术,可以将多个 GPU 直接连接起来,形成一个高性能计算集群或深度学习系统此外,NVLink引入了统一内存的概念,支持连接的 GPU 之间的内存池,这对于需要大型数据集的任务来说是一个至关重要的功能。

而NVSwitch 是一种高速交换机技术,可以将多个 GPU 和 CPU 直接连接起来,形成一个高性能计算系统。

在NVLink Switch支持下,英伟达“大力出奇迹”地将72块B200连接在一起,最终成为“新一代计算单元”GB200 NVL72。一个像这样的“计算单元”机柜,FP8精度的训练算力就高达720PFlops,直逼H100时代一个DGX SuperPod超级计算机集群(1000 PFlops)。

英伟达透露,这一全新的芯片将在2024年晚些时间上市。目前,亚马逊、戴尔、谷歌、Meta、微软、OpenAI、特斯拉都已经计划使用Blackwell GPU。

“打包批发卖卡”的方式也符合大模型公司的用卡需求。将多个GPU互联“打包”成数据中心,更符合大模型公司和云服务商的购买形式。英伟达2023财年财报显示,英伟达的数据中心业务有40%的收入来自超大规模数据中心与云服务商。

截至美东时间3月18日美股收盘,英伟达股价884.550美元,总市值2.21万亿美元。